AI

[AI] 간단한 선형 모델로 이해하는 가중치 감쇠(Weight Decay)

Nhahan

2024. 9. 19. 07:02

가중치 감쇠

- 가중치 감소: 매번 업데이트할 때마다 가중치가 조금씩 줄어듦.

- 복잡도 제어: 가중치가 작아지면 모델의 복잡도가 낮아져, 과도한 학습을 방지.

- 일반화 성능 향상: 모델이 훈련 데이터에 과적합되지 않고, 새로운 데이터에도 잘 동작하게 됨.

가중치 감쇠(Weight Decay)는 정규화(Regularization) 기법 중 하나이다. 정규화는 머신러닝 모델이 과적합(Overfitting) 되는 것을 방지한다.

간단한 선형 모델

이 있다.

이 때 손실 함수를

라고 한다.

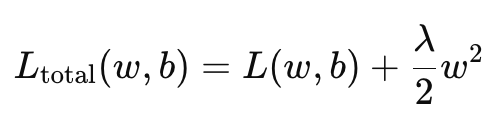

가중치(Weight Decay)를 적용한 전체 손실 함수는

이다.

🤔🤔

근데 왜 𝜆/2에 w^2를 하는가?

w^2를 미분하면 2w가 되는데, 이 때 1/2가 있으면 미분 값이 λw로 간단해지기 때문이다.

왜 굳이 가중치에 제곱을 하는가?

w가 음수일 경우, 양수로 만들기 위함이다.

그렇다면, w를 제곱하지 않고 절대값을 사용하면 되지 않는가?

절대값을 사용하는 방식을 'L1 정규화'라고 한다. 위 내용은 'L2 정규화'에 대한 내용이다. (일반적으로 L2 정규화를 사용한다)